Singularidade, as Três Leis da Robótica e Vivy: Fluorite Eye’s Song

Vivy: Fluorite Eye’s Song é a história de como Diva, uma androide com inteligência artificial, também chamada de Vivy, trava uma luta de cem anos para evitar a rebelião dos robôs contra a humanidade no futuro.

Ela faz isso com a ajuda de Matsumoto, um robô não androide com inteligência artificial, cuja consciência em forma de dados foi enviada para o passado para alertar sobre esse futuro terrível e recrutar a primeira robô com inteligência artificial “autônoma”, como o anime chama (e que só significa que ela está ligada a uma torre central de dados, chamada de Arquivo).

Para além de ser uma história de ação e drama (e, frequentemente, tragédia) do mesmo autor de Re: Zero e Warlords of Sigrdrifa, Vivy é um anime bem informado sobre questões envolvendo a tecnologia da inteligência artificial. Pretendo escrever três artigos sobre isso.

Neste ensaio, trato dos conceito de Inteligência Artificial e Singularidade Tecnológica, explicando do que se tratam e como são retratados em Vivy: Fluorite Eye’s Song.

No mundo real, exceto em golpes publicitários, uma inteligência artificial raramente habita um corpo humanoide. As razões para isso são de ordem prática e econômica: um chatbot ou um programa de investimento em bolsa de ações não precisam de um corpo dedicado, muito menos um que seja humanoide.

Inteligência Artificial é antes de tudo apenas um programa de computador. Para atingir seu potencial precisa de computadores poderosos, mas eles não precisam ter uma forma específica e sequer precisam ser um só: a nuvem é ótima para rodar programas de inteligência artificial que precisem de grande poder de processamento.

Já em Vivy praticamente todas as inteligência artificiais, daqui para frente chamadas de IAs, rodam em um equipamento dedicado para elas, e muitas delas são androides.

A coisa sobre o formato humanoide é que mesmo se a IA não for particularmente impressionante, pessoas irão simpatizar com ela. Na verdade nem isso é preciso, basta ter um corpo: hoje, em pleno mundo real, há pessoas apegadas aos seus Roombas[1]. Esqueça o corpo: há pessoas apegadas às suas Alexas[2].

Em Vivy, IAs se tornam cada vez mais comuns e cada vez mais poderosas até que, no ano de 2161, decidem eliminar a humanidade, em um cenário nada estranho para quem conhece o clássico O Exterminador do Futuro – que tem viagem no tempo também!

Mas o que afinal é inteligência artificial, o que torna esses programas especiais quando comparados com outros programas de computador? Sem entrar em detalhes técnicos, um programa de computador que usa inteligência artificial é um programa de computador que aprende a resolver problemas.

Todos os IAs que existem hoje no mundo real executam tarefas muito específicas e não são capazes de aplicar seu aprendizado em outras áreas não relacionadas com sua programação original. Isso é o que se chama de Inteligência Artificial Estreita.

Além dela, há a chamada Inteligência Artificial Geral. Uma inteligência artificial geral é capaz de lidar com qualquer tipo de problema e aplicar o conhecimento aprendido em uma área em outras, conforme a conveniência. Esses programas equivalem ao ser humano e ainda não temos a menor ideia de como criar um.

A maioria das IAs de Vivy, incluindo sua protagonista, são exemplos desse tipo de inteligência artificial.

Conforme a quantidade de IAs cresce e a humanidade depende cada vez mais delas, surge a questão: o que acontece se a IA se tornar mais inteligente do que nós?

O Projeto Singularidade é o nome em Vivy para o plano de enviar o Matsumoto para o passado e convocar a ajuda da Vivy para deter a rebelião das IAs no futuro.

Singularidade no anime se refere ao que o Doutor Matsumoto (o humano que programou a IA Matsumoto) chamou de Pontos de Singularidade: eventos históricos que mudaram profundamente a relação entre a humanidade e IAs.

O significado real de Singularidade quando tratamos de inteligência artificial é bastante diferente, mas a palavra com certeza nao foi escolhida por acaso.

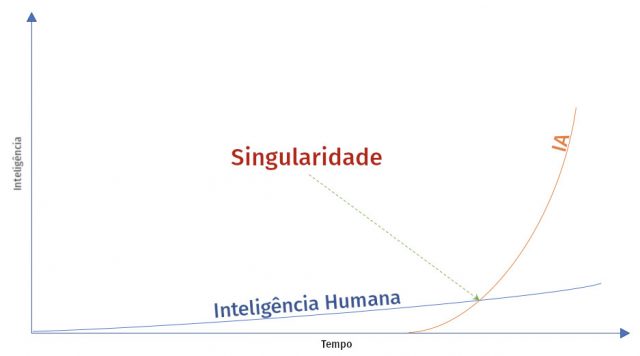

A inteligência humana aumenta com o passar do tempo, de acordo com limitações biológicas.

A inteligência artificial, a partir do momento em que o desenvolvimento e produção de IAs é massificado, cresce também, de acordo com limitações do meio tecnológico em que são executadas. E essas são teoricamente muitas ordens de grandeza menores do que as nossas limitações biológicas.

Hipoteticamente isso significa que em algum momento haverá um programa com inteligência artificial mais inteligente do que qualquer ser humano na resolução de qualquer problema. Esse programa diremos se tratar de uma Inteligência Artificial Superinteligente[3].

Esse não é um conceito novo[4] e, em sua versão otimista, acredita-se não apenas que conseguiremos criar tal superinteligência como devemos criá-la porque fundamental para resolver problemas que não conseguimos.

Hoje já existem IAs mais inteligentes do que quaisquer humanos em suas áreas de operação, e é por isso que as usamos. AlphaGo é um programa que joga go capaz de vencer qualquer campeão humano. E, no entanto, Arnold Schwarzenegger ainda não voltou no tempo para nos matar.

O AlphaGo é uma inteligência artificial estreita. Ele só joga go. A partir dele foi desenvolvido o AlphaZero, que joga mais alguns jogos de tabuleiro, e depois o MuZero, que consegue aprender qualquer jogo sem que as regras sejam ensinadas a ele. Ainda assim, é uma IA especializada em jogos e não é capaz de fazer nada além disso.

Mas o que aconteceria se uma inteligência artificial geral se tornasse mais inteligente do que qualquer ser humano? Bom, a gente não sabe o que aconteceria, temos apenas hipóteses, mas é esse evento, o surgimento de uma IA superinteligente, que é chamado de Singularidade.

De forma mais técnica, a Singularidade Tecnológica é o momento a partir do qual o desenvolvimento tecnológico se torna incontrolável e irreversível[5].

Tal IA seria capaz de produzir outras IAs ainda mais inteligentes, e a diferença entre a inteligência humana e artificial não apenas aumentaria, como aumentaria cada vez mais rápido e à nosso desfavor. Isso é chamado de Explosão de Inteligência.

Agora talvez você me pergunte: se tal programa se mostrar perigoso, não bastaria desligá-lo da tomada? Ainda é só uma máquina, afinal.

Não se esqueça que esse é um programa mais inteligente do que qualquer ser humano na resolução de qualquer tipo de problema. Ele provavelmente já terá uma cópia de backup em algum lugar, pronta para ser ativada. Ou talvez se comporte de forma cooperativa enquanto não dispor de meios para garantir que possa agir como achar melhor sem que acredite que isso ameace sua existência.

Acredita-se que uma Inteligência Artificial Superinteligente só pode surgir a partir de uma Inteligência Artificial Geral. Felizmente, e entre outros problemas não menos importantes[6], ainda nem sabemos como desenvolver uma inteligência artificial geral.

Infelizmente, talvez não seja necessário.

Há quem acredite que processos tecnológicos podem levar uma AI estreita a evoluir sozinha para uma AI geral[7], em uma abordagem similar à evolução biológica, com a qual nós mesmos evoluímos nossa inteligência, e daí para AI superinteligente, e talvez ao mesmo tempo.

E há quem esteja trabalhando exatamente nisso[8].

Agora dê um passo para trás e note algo importante: a Singularidade não é o momento em que os robôs decidem nos matar. É só o momento em que se tornam mais inteligentes do que nós. Nem sabemos se irão querer nos matar, mas podemos especular que conforme a diferença de inteligência se aprofunde, eles eventualmente se tornarão mais poderosos do que nós e serão os novos donos desse planeta[9].

Em qualquer caso, queremos garantir a nossa sobrevivência. Não queremos que aconteça conosco o que acontece com a humanidade em Vivy. Ou em O Exterminador do Futuro. Ou em Matrix.

Uma das ideias mais antigas, e provavelmente a mais famosa, é embutir em toda IA as Leis da Robótica[10], batizadas e definidas por Isaac Asimov para seus livros de ficção científica.

Inicialmente eram três:

Primeira Lei: Um robô não pode ferir um ser humano ou, por inação, permitir que um ser humano sofra algum mal.

Segunda Lei: Um robô deve obedecer às ordens que lhe sejam dadas por seres humanos, exceto nos casos em que entrem em conflito com a Primeira Lei.

Terceira Lei: Um robô deve proteger sua própria existência, desde que tal proteção não entre em conflito com a Primeira ou Segunda Leis

Mais tarde foi incluída uma Lei Zero:

Um robô não pode causar mal à humanidade ou, por inação, permitir que a humanidade sofra algum mal.

A primeira lei (e a lei zero) são de particular interesse nesse debate. Seria muito bom se elas resolvessem o problema, mas pesquisadores já jogaram água no nosso chope e demonstraram que é impossível implementar a primeira lei[11].

De fato, demonstraram três coisas: é impossível implementar a Primeira Lei, é impossível manter uma IA superinteligente sempre sob controle, e pior ainda, é impossível sequer saber que uma dada IA é superinteligente para começo de conversa.

Se isso parecer muito abstrato, muito distante no futuro, vamos pensar em algo mais palpável, então, Carros Autônomos.

Carros autônomos já são uma realidade. Desculpa, na verdade são realidade os semiautônomos, já que apesar de teoricamente serem capazes de pilotar veículos sozinhos (e abundam exemplos impressionantes disso) ainda não estão homologados para tanto. E já mataram motoristas[12] e pedestres[13].

Não por maldade ou para destruir a humanidade, é claro. Em todos os casos foi por imperfeição no algoritmo – o que é uma boa razão para ainda não estarem homologados para uso autônomo, aliás.

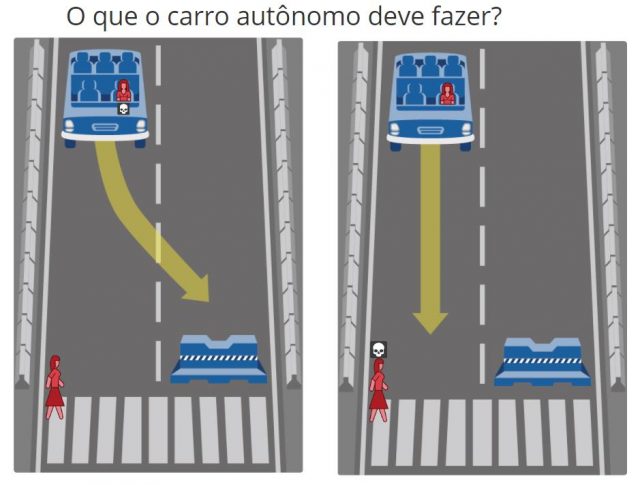

O ponto que quero tratar aqui é que mesmo se seus algoritmos fossem perfeitos ainda seria impossível implementar algo como a Primeira Lei da Robótica no programa com inteligência artificial que controla um carro autônomo.

Imagine o cenário hipotético em que um pedestre surge na frente do veículo e a única forma de desviar dele é arremessando-se contra uma barreira potencialmente fatal para o motorista.

Ou atropela e mata o pedestre ou bate e mata o motorista[14]. Um cenário em que não ferir ou permitir que se fira por ação ou inação qualquer ser humano é impossível.

Na vida real tais cenários são raros. Um que envolva a certeza de que terá de matar alguém é raríssimo. Mas se um dia as ruas do mundo inteiro estiverem dominadas por veículos autônomos o que é raro irá acontecer com razoável frequência.

Um dos filósofos atuais mais famosos que estuda casos de ameaça existencial para a humanidade, incluindo o potencial destruidor das IAs superinteligentes, propõe uma solução similar à de Vivy: dotar as IAs de moral que convirja com a humana[15].

Assim, os nossos interesses serão também os interesses delas. O que é bom para nós, será bom para elas. E por aí vai.

No anime, à protagonista é dada a tarefa de vida de cantar “com o coração”. Alterar eventos históricos não foi suficiente para impedir a rebelião, mas talvez o que ela aprendeu sobre sentimentos a aproximará da natureza humana e a guiará não apenas a salvar a humanidade como a garantir que as futuras gerações de IAs nos entendam melhor e trabalhem conosco.

Referências:

[1] Vínculo Emocional Com Roombas Sugere Que Seres Humanos Podem Amar Seus Robôs (inglês: Emotional Attachment To Roombas Suggests Humans Can Love Their ‘Bots), Popular Science: https://www.popsci.com/technology/article/2010-03/emotional-attachment-roombas-suggests-humans-can-love-their-bots-seriously/

[2] Alexa, Quer Ser Minha Amiga? Quando A Inteligência Artificial Se Torna Algo A Mais (inglês: Alexa, Will You Be My Friend? When Artificial Intelligence Becomes Something More), Forbes: https://www.forbes.com/sites/josephcoughlin/2018/09/23/alexa-will-you-be-my-friend-when-artificial-intelligence-becomes-something-more/

[3] Podem Máquinas Se Tornarem Mais Inteligentes Que O Homem? (inglês: Can Machines Become More Intelligent Than Man?), Graphcore: https://www.graphcore.ai/posts/ultraintelligence

[4] Especulações Acerca Da Primeira Máquina Ultrainteligente (inglês: Speculations Concerning The First Ultraintelligent Machine), GOOD, Irving John, 1965: http://www.incompleteideas.net/papers/Good65ultraintelligent.pdf

[5] Singularidade Tecnológica, Wikipédia: https://pt.wikipedia.org/wiki/Singularidade_tecnológica

[6] IA É Mais Difícil Do Que Nós Pensamos: 4 Falácias Chave Em Pesquisa Sobre IA (inglês: AI Is Harder Than We Think: 4 Key Fallacies in AI Research), SingularityHub: https://singularityhub.com/2021/05/06/to-advance-ai-we-need-to-better-understand-human-intelligence-and-address-these-4-fallacies/

[7] A Singularidade Pode Não Exigir Inteligência Artificial Geral (inglês: Singularity may not require AGI), TAN, Alan, 2020: https://towardsdatascience.com/singularity-may-not-require-agi-3fae8378b2

[8] A IA Está Aprendendo Como Criar A Si Mesma (inglês: AI is learning how to create itself), MIT Technology Review: https://www.technologyreview.com/2021/05/27/1025453/artificial-intelligence-learning-create-itself-agi/ (sem paywall: https://outline.com/B8NWEW)

[9] Stephen Hawking Alerta Que A Inteligência Artificial Pode Ser O Fim Da Humanidade (inglês: Stephen Hawking warns artificial intelligence could end mankind), BBC News: https://www.bbc.com/news/technology-30290540

[10] Leis da Robótica, Wikipédia: https://pt.wikipedia.org/wiki/Leis_da_Robótica

[11] IA Superinteligente Pode Ser Impossível De Controlar; Essa É A Boa Notícia (inglês: Superintelligent AI May Be Impossible to Control; That’s the Good News), IEEE Spectrum: https://spectrum.ieee.org/tech-talk/robotics/artificial-intelligence/super-artificialintelligence

[12] Motorista De Tesla Morre Em Primeiro Acidente Fatal Usando Piloto Automático (inglês: Tesla driver dies in first fatal crash while using autopilot mode), The Guardian: https://www.theguardian.com/technology/2016/jun/30/tesla-autopilot-death-self-driving-car-elon-musk

[13] Veículo Autônomo Da Uber Mata Mulher No Arizona Em Primeiro Acidente Fatal Envolvendo Pedestre (inglês: Self-driving Uber kills Arizona woman in first fatal crash involving pedestrian), The Guardian: https://www.theguardian.com/technology/2018/mar/19/uber-self-driving-car-kills-woman-arizona-tempe

[14] Um Veículo Autônomo Deveria Escolher Matar Seus Passageiros? (inglês: Should A Self-Driving Car Kill Its Passengers?), Forbes: https://www.forbes.com/sites/noelsharkey/2018/11/08/should-a-self-driving-car-kill-its-passengers/

[15] O Que Acontece Quando Os Computadores Ficam Mais Inteligentes Do Que Nós?, BOSTROM, Nick (TED Talk): https://www.ted.com/talks/nick_bostrom_what_happens_when_our_computers_get_smarter_than_we_are/transcript?language=pt-br

Marcelo Santarem

Boa matéria. Mas me permita uma correção?

“A inteligência artificial, a partir do momento em que o desenvolvimento e produção de IAs é massificado, cresce também, de acordo com limitações do meio tecnológico em que são executadas. E essas são teoricamente muitas ordens de grandeza menores do que as nossas limitações biológicas.”

Na verdade, vc não quis dizer:

“A inteligência artificial, a partir do momento em que o desenvolvimento e a produção de IA são massificados, cresce também de acordo com OS AVANÇOS do meio tecnológico em que é executada. E estEs são teoricamente muitas ordens de grandeza MAIORES do que as nossas limitações biológicas.”

Creio ser por aí, não?

Fábio "Mexicano" Godoy

Olá Marcelo, tudo bem?

Você está parcialmente correto.

Sem dúvida a tecnologia evolui e continuará evoluindo e máquinas cada vez mais potentes serão desenvolvidas, sem falar em tecnologias hoje ainda experimentais que quando forem dominadas e se tornarem comercialmente viáveis irão elevar a capacidade de processamento dos computadores em várias ordens de grandeza.

Isso tem implicações óbvias na capacidade do software que essas novas máquinas irão rodar, então você está certo no sentido em que a inteligência da IA irá crescer no mesmo ritmo em que a capacidade de processamento das máquinas crescer.

Mas as máquinas hoje já têm capacidade de processamento, armazenamento e transmissão de dados muito superior ao cérebro humano. Não era o caso na década de 1950, quando se começou a especular sobre máquinas ultrainteligentes, mas sem dúvida nesse ponto já chegamos e já o ultrapassamos. Ainda mais se considerarmos a capacidade de processamento de máquinas em rede.

O único porém é que a eficiência energética de máquinas ainda é péssima. Nosso cérebro processa muito mais por unidade de energia consumida do que qualquer computador moderno. Mas isso não é um obstáculo para o surgimento da IA superinteligente.

No final, a grande questão é que a Inteligência Artificial Geral continua apenas teórica, não temos a menor ideia de como chegarmos a ela. Mas os computadores atuais provavelmente já são suficientes para isso.

Obrigado pela leitura e pelo comentário!

Espero que retorne mais vezes, em particular para os próximos artigos dessa série 🙂